Configurarea serverelor

Instalația în sine nu cauzează probleme sau dificultăți. Tot ceea ce este necesar este de a crea o matrice RAID1 + HotSpare, deoarece avem 3 HDD. Conectați externe DVD-ROM și de boot (da, ne-am salvat cu succes și a cumpărat un server cu nici un DVD-ROM) din aceasta (care aveți nevoie pentru a scrie imaginea descărcate pe disc, nu va amintesc). La prima întrebare, noi răspundem că pentru noi cel mai apropiat limba română, dar în a doua vom alege localizarea engleză și aspect engleză.

După instalare, va trebui să introduceți parola pentru administratorul local.

Configurare acces de la distanță

Primul lucru pe care trebuie să configurați serverul svezheproinstalleny pentru conexiunea la distanță prin intermediul PDR. Aici și apoi voi folosi comenzi la cmd.exe (cutie neagră) și nu sconfig.cmd (caseta albastră). Este un pic mai complicat, dar interesant). De asemenea, script-uri (sau aplica pentru descărcare în arhiva) creat pentru majoritatea acțiunilor.

Deci, pentru a efectua mai multe comenzi [01_RDP.cmd]:

Suntem acum gata pentru a conecta de la distanță la serverul nostru.

Introduceți domeniul, instala drivere, echipa de rețea

Redenumirea server [02_ServerRename01.cmd și 02_ServerRename02.cmd]:

netdom renamecomputer% numecomputer% / newname: shv01

închidere -r -f -t 0

Iar acum puteți intra în domeniu, și apoi reporniți [03_InDomain.cmd]:

netdom alătura% numecomputer% / domeniu: exemplu / userd: rublin / passwordd:

Adăugat la grupul de administratori locali Admins (alineatul 3), putem merge la server sub BackOffice domeniu uchetki.

Configurarea firewall-ul [04_Firewall.cmd]:

De asemenea, permite toate alineatul 4 (după 4.2 necesară repornirea)

Copiați partiția de sistem FAR - manager de fișiere gratuit (începe lampă c: \ departe \ de departe)

După instalarea driverelor, puteți (și ar trebui) să creeze o echipă cu interfețe de rețea. Pentru a face acest lucru, calea "C: \ Program Files \ Intel \ NCS2 \ Scripts" au script-urile dorite. Învățăm numere de interfață script Adapter_EnumerateProperties.vbs (cscriptAdapter_EnumerateProperties.vbs1 rula pentru prima interfață). Team_CreateTeam.vbs Script crea TEAM [05_TEAM.cmd]:

Toate aceste acțiuni sunt repetate pentru al doilea server.

Pentru a putea controla Hyper rol - V prin script-uri PowerShell. set PowerShell Management de bibliotecă pentru Hyper-V rula mai târziu consola de comandă poate fi:

Conectarea la server la sistemul de stocare

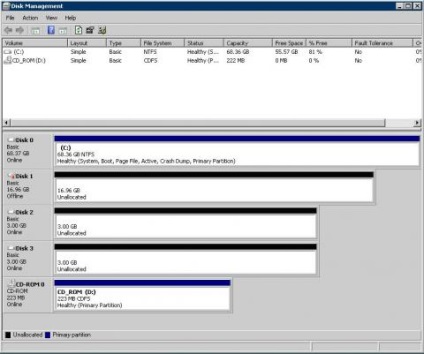

Pentru buna funcționare a serverului cu stocare necesară pentru a stabili rolul MPIO. Fără acest server conectat vede luna ca două discuri diferite:

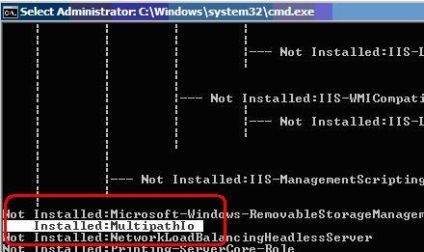

Turn rol MPIO:

Verificați prin executarea oclist

Adăugarea de suport pentru MPIO pentru SAN nostru (serverul va reporni automat):

Apoi, trebuie să instalați componenta failover Clusteing (punctul 11).

De asemenea, este necesar să se corecteze registru care urmează să fie utilizate pentru conectarea la stocare SAS. Ramura HKEY_LOCAL_MACHINE \ SYSTEM \ CurrentControlSet \ Services \ HpCISSs2 \ Parameters \ BusType schimbare 8 A

Acum, cu MMC, Computer Management completare snap-in pentru a vedea Luna de pe listă. Formatați în NTFS.

Toate aceste măsuri trebuie să fie efectuate pe ambele servere (acțiunile sunt identice), în plus față de crearea și partiții de formatare. În acest sens, sistemul de stocare este finalizat. Este timpul pentru a asambla un cluster!

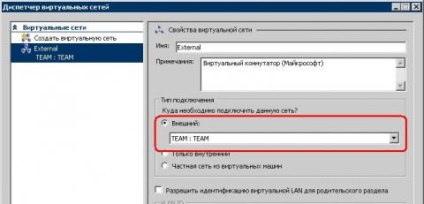

Crearea de rețele virtuale

Înainte de a crea un cluster, trebuie să creați servere virtuale de pe rețea. Pentru a face acest lucru, în MMC, de completare snap-in Hyper-V Manager de clic pe "Manager de Virtual Network ..." și selectați interfață externă apel TEAM

După aceea, este de dorit pentru a reporni serverul, care este ceea ce vom face.

configurare Verificați

Mai mult, în MMC consola, fixați Failover Cluster Manager de (a început întotdeauna pe 64 de biți Windows 7 sau Vista - nu este scris nicăieri, dar pe de altă parte nu funcționează.) Failover clustering, executați testul: faceți clic pe Verificare configurare ... Ca rezultat, avem de a obține un raport, că totul este bine.

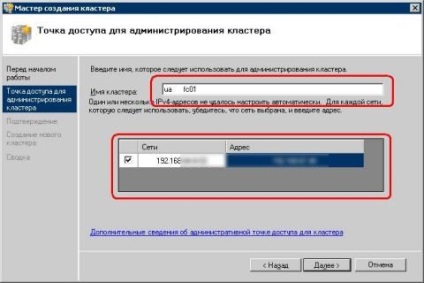

Crearea unui cluster

Conform rezultatelor obținem crearea raportului.

Activarea CSV

Acum vom vedea consola de administrare de cluster. Inclusiv suport pentru Cluster Shared Volum: faceți clic pe Activare Cluster Volumele la comun ... Următorul în grup comun Volumele adăuga depozitul: faceți clic pe Adăugați spațiu de stocare. După această secțiune la stocare va fi disponibil în C: \ ClusterStorage \ Volum1 \

La crearea de configurare Hyper-V în cluster este completă.

Clustermanagementului în continuare și mașini virtuale în cluster va fi efectuată cu MMC, Manager Failover Cluster snap-in (nu uitați că ar trebui să fie pe zapuchena x64 Windows 7 sau Vista). Creați o mașină virtuală de test: în consolă, faceți clic pe Servicii și aplicații - Mașini virtuale - Crearea unei mașini virtuale ... - 1-HV01, în plasarea specifica C: \ ClusterStorage \ Volum1 \ VirtualMachines

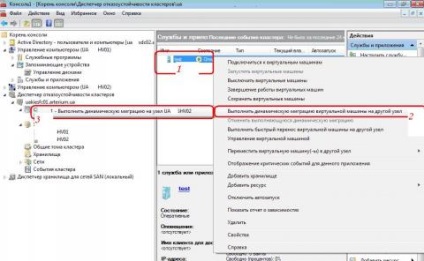

Instalați sistemul de operare pe o mașină virtuală, creați un director partajat. Copiați orice fișier mare și lăsați ping pentru a verifica dacă migrația live va avea loc fără „la locul de muncă“. Dev acum migrat la un alt nod: În consola, selectați Dev nostru, faceți clic pe Executare dinamic de migrare mașină virtuală la un alt nod.

Pentru a simula eșecul de un nod pe care doriți să dezactivați rețeaua de server (pe toate interfețele de rețea, inclusiv Hearbit). În acest caz, mașina virtuală va fi mutat automat la al doilea nod. Primul nod (cel care a intrat în off-line) vor fi marcate ca „nu funcționează“, iar intregul grup va fi marcat ca fiind eșuat. Acesta va fi servicii simple, scurte virtuale de mașini, și posibila pierdere a datelor de utilizator - aceasta este o repornire greu. Când primul nod revine la sistem, Dev să rămână la al doilea nod pentru transferul manual.